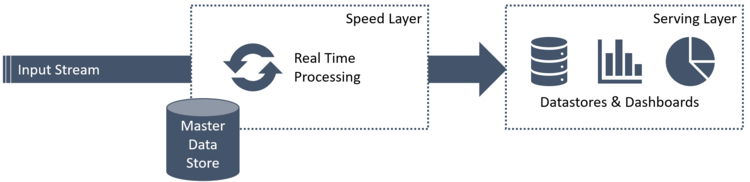

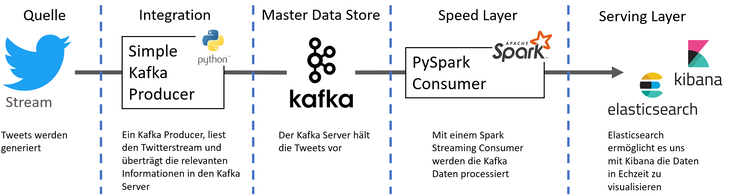

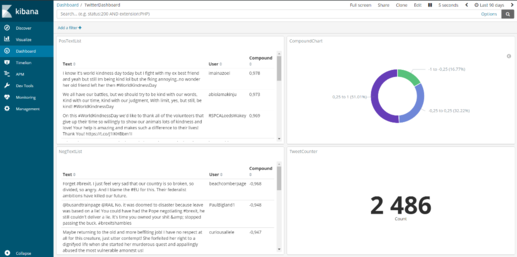

Im Wandel der Digitalisierung und der Erweiterung der digitalen Forschungsfelder durch erhöhte Rechenleistung, Vereinfachung von Machine Learning Prozessen und vielen weiteren technologischen Fortschritten, haben sich die letzten Jahre eine Vielzahl neuer Möglichkeiten und Herausforderungen für Unternehmen eröffnet, welche nicht selten mit Datenmanagement, Volumenskalierung und Geschwindigkeit zu tun haben. Wie man diese Herausforderungen lösen kann, zeigen wir im Folgenden anhand einiger Streaming-Konzepte und der Umsetzung einer Echtzeit-Sentiment-Analyse von Twitterstream-Daten mit Apache Kafka, Apache Spark und Elasticsearch.